W erze, gdy sztuczna inteligencja wkracza w każdy aspekt naszego życia, nawet tradycyjne papierowe gazety nie są bezpieczne. Niedawny incydent w pakistańskiej gazecie Dawn – jednej z najstarszych i najbardziej szanowanych w regionie – ujawnił, jak AI, takie jak ChatGPT, zaczyna pisać artykuły. Ale co się dzieje, gdy maszyna popełni błąd, a redaktor go nie zauważy? To nie science fiction, to rzeczywistość 2025 roku.

Błąd, który obiegł świat

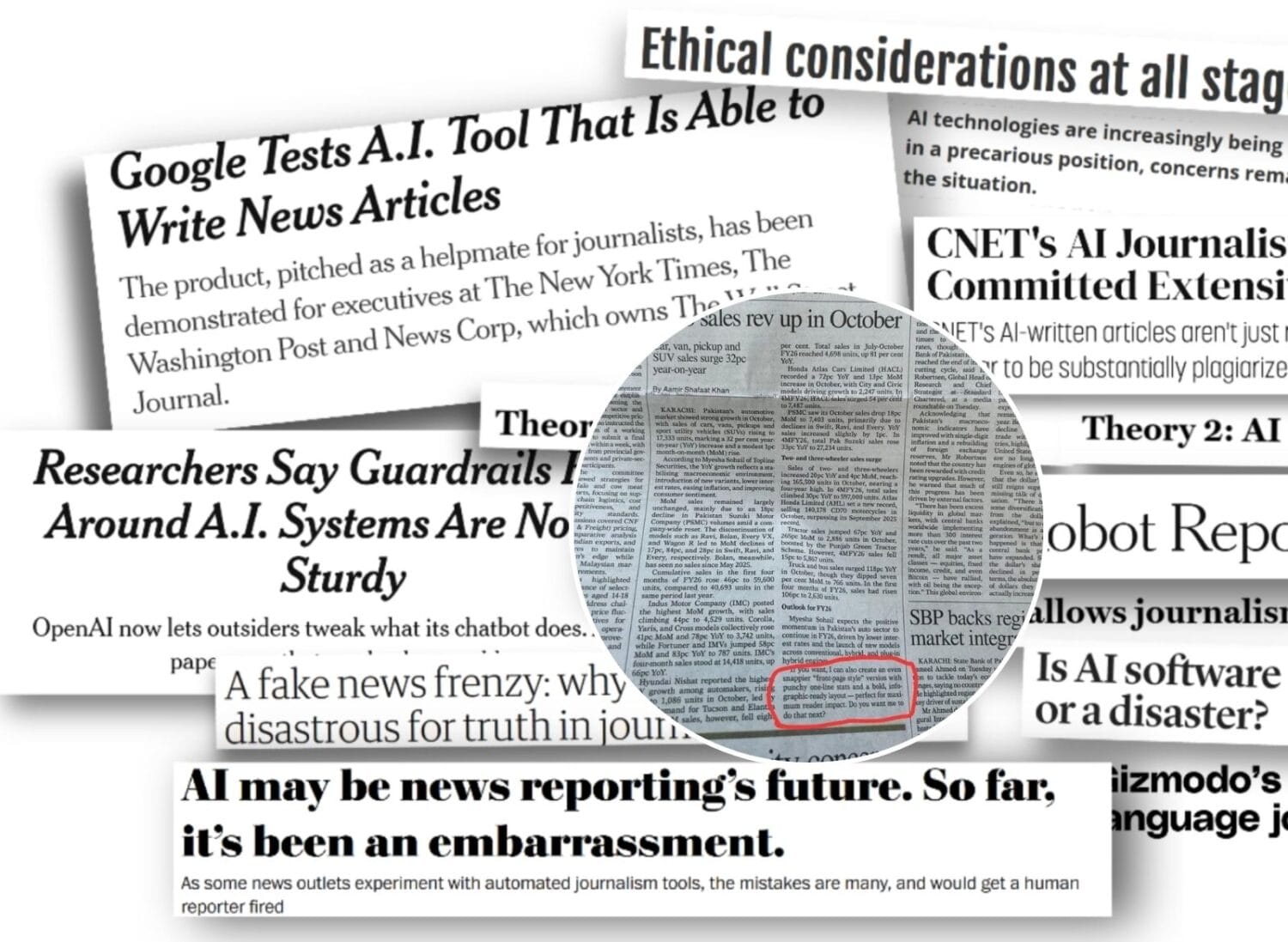

12 listopada 2025 roku w drukowanym wydaniu Dawn ukazał się artykuł zatytułowany „Auto sales rev up in October” (Sprzedaż samochodów nabiera tempa w październiku). Tekst analizował wzrost sprzedaży pojazdów w Pakistanie, ale na końcu pojawiły się dziwne frazy: „Do you want me to do that next?” i inne, które wyglądały jak polecenia dla AI lub niedokończone odpowiedzi ChatGPT. Czytelnik Priyanshu Ratnakar udostępnił zdjęcie na platformie X (dawniej Twitter), pisząc: „wake up babygirl, now news is written by chatgpt”. Post szybko stał się viralem, zdobywając ponad 69 tysięcy polubień i tysiące udostępnień.

Gazeta szybko zareagowała. W wersji online artykuł został poprawiony, a redakcja dodała notatkę: „This newspaper report was originally edited using AI, which is in violation of Dawn’s current AI policy.” To przyznanie się do winy – AI było użyte do edycji, ale bez odpowiedniej kontroli. Redaktor przeprosił, ale incydent wywołał falę krytyki. Użytkownicy X żartowali: „Editor needs to be fired along with writer” czy „Pakistan Ka Unpaid Intern Hoga” (To musi być nieopłacany stażysta z Pakistanu).

To nie pierwszy raz, gdy AI wkrada się do prasy. W 2023 roku Sports Illustrated opublikowało artykuły generowane przez AI, z fałszywymi autorami i zdjęciami. A w marcu 2025 roku włoska gazeta Il Foglio wydała całe wydanie stworzone przez AI – od artykułów po nagłówki, a nawet ironię.

Jak AI zmienia dziennikarstwo?

Sztuczna inteligencja nie jest nowością w mediach. Według badań z października 2025 roku, aż 9% artykułów w amerykańskich gazetach jest przynajmniej częściowo generowanych przez AI. Narzędzia jak ChatGPT pomagają w pisaniu szkiców, podsumowań czy nawet pełnych tekstów. Na przykład, San Francisco Chronicle używa AI do rekomendacji restauracji na podstawie archiwalnych recenzji. Brytyjskie Mirror i Express publikowały artykuły pisane przez AI już w 2023 roku.

Zalety są oczywiste:

- Szybkość: AI może przetworzyć dane i napisać artykuł w sekundy.

- Efektywność: Pomaga w rutynowych zadaniach, jak podsumowania raportów finansowych.

- Dostępność: W krajach rozwijających się, jak Pakistan, gdzie redakcje są małe, AI wypełnia luki.

Ale wady? Brak kontekstu, błędy faktograficzne i utrata autentyczności. W maju 2025 roku główne gazety opublikowały fałszywą listę książek na lato, wygenerowaną przez AI – z nieistniejącymi tytułami. To pokazuje, jak „AI slop” – bezsmakowa, spamowa treść – zalewa media.

Przyszłość: Człowiek vs. Maszyna

Czy AI zastąpi dziennikarzy? Na razie nie, ale integracja postępuje. Newsroomy jak The Atlantic eksperymentują z AI do tworzenia narzędzi dla czytelników. Jednak incydenty jak ten w Dawn podkreślają potrzebę regulacji. Etyczne wytyczne, jak te w Dawn, zakazują używania AI bez nadzoru.

W Polsce? Choć jeszcze nie widzimy takich błędów w Gazecie Wyborczej czy Rzeczpospolitej, trend jest globalny. AI pomaga w tłumaczeniach czy analizie danych, ale redakcje muszą być czujne.

Podsumowanie

Incydent w Dawn to dzwonek alarmowy: AI jest potężne, ale bez ludzkiego oka może prowadzić do kompromitacji. Czy następnym razem przeczytasz gazetę i zastanowisz się, kto naprawdę napisał artykuł? Przyszłość dziennikarstwa to hybryda – maszyna plus człowiek. Ale pamiętaj: AI nie ma intuicji, empatii ani odpowiedzialności. To my, czytelnicy, musimy domagać się transparentności.